LES ENJEUX

DE LA TEXTUALITÉ

NUMÉRIQUE

INTRODUCTION

-----

Le transfert d’un texte d’une matérialité papier à une matérialité numérique le transforme formellement et physiquement. Il prend d’autres formes et s’ouvre à d’autres usages. S’interroger sur la textualité numérique est une manière de comprendre comment un designer graphique participe à la lisibilité, à la structuration et à la compréhension d’un texte. Le passage d’une lecture papier à une lecture-écran modifie les processus de reconnaissance des formes, des formats et des contenus. En effet, l’écran propose de nouveaux usages qui transforment la structure sémantique de l’information et induit de nouvelles gestuelles, pratiques de lecture et consultations du texte.

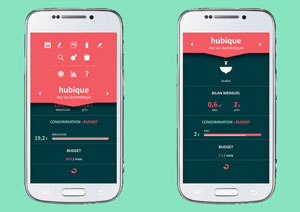

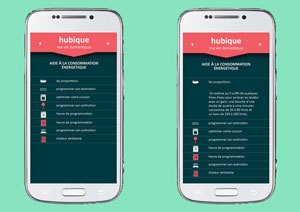

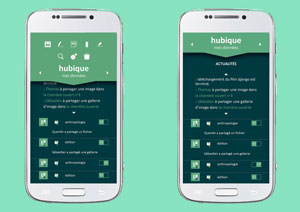

Mon parcours au sein de l’École supérieure d’art des Pyrénées – Pau-Tarbes option Design Graphique Multimédia m’a permis d’expérimenter les usages et les enjeux de la conception éditoriale dans plusieurs contextes. Lors de mon DNAP , je me suis interrogée sur la manière de structurer et rendre lisible les données du quotidien par le biais de l’écran d’un téléphone portable. J’avais proposé une application nommée «hubique» à mi-chemin entre la télécommande (ordre) et le tableau de bord (analyse, supervision). Il s’agissait d’une application organisatrice de vie, c’est-à-dire un écosystème numérique interconnecté qui permettait l’archivage et l’explicitation de nos petites histoires quotidiennes à travers trois moments de vie: sociale, numérique et domestique. Ce projet m’avait permis d’avoir une première approche de la lisibilité et de la structuration de données sur écran, ce qui m’a amené à vouloir approfondir mes connaissances sur les transformations éditoriales.

Au fil de ces trois années d’études, je me suis intéressée à la manière dont on donnait à lire ou à voir un contenu textuel et/ou iconographique en fonction de son support de diffusion et de son usage. Différentes expérimentations imprimées ou numériques m’ont permis d’examiner les relations qu’entretiennent le fond, la forme, le support et l’usager, afin d’en comprendre les enjeux de leurs agencements. Une édition papier ou numérique n’implique pas de la même manière, le couple support/message ni les mêmes paradigmes , ni la même énonciation éditoriale , ni les mêmes éléments de paratexte et ni la même gestuelle. Il est important de discerner et d’assimiler l’ensemble des éléments constitutifs d’une édition dans le but de comprendre le sens des différentes échelles typographiques. Chaque élément d’un texte a un rôle structurant et porteur de sens qui façonne la visibilité et la lisibilité.

Dans cette étude, nous partons du constat que les évolutions du texte numérique ne prennent pas, dans la majorité des cas, suffisamment en compte la question de la lecture à l’écran. En effet, celle-ci, a ses propres spécificités notamment par rapport à la lisibilité, la structuration, les usages. Nous sommes encore aujourd’hui trop souvent dans un miroir de procédés et processus de conception du papier. Or, des dispositifs et des pensées natives des supports de lecture numérique existent. Pour comprendre dans quelle mesure l’ère numérique a modifié les formes éditoriales, nous nous appuierons sur les travaux de designer graphique et/ou théoriciens comme Jost Hochuli, Robin Kinross ou encore Matthew Carter tout en mobilisant également les travaux d’historiens du livre comme Roger Chartier ou les écrits de spécialistes des sciences de l’information et de la communication comme Emmanuël Souchier et Yves Jeanneret.

La prise en compte de l’ensemble des signes graphiques visibles ou non visibles d’une édition permet de comprendre comment un designer graphique procède pour optimiser et conditionner la réception d’un texte. De plus, en se questionnant sur le texte et ses mutations, nous chercherons à comprendre si, comme le dit Roger Chartier , un texte change réellement de nature en fonction de son support: «Un même texte n’est plus le même lorsque change le support de son inscription, donc, également, les manières de le lire et le sens que lui attribuent ses nouveaux lecteurs». Dans le but de répondre à ces interrogations, l’analyse est structurée en trois parties. La première interrogera la microtypographie sur papier et sur écran dans l’intention de comprendre l’influence de la lettre sur la lisibilité d’un texte. Nous nous demanderons si les normes et processus de la lisibilité restent les mêmes d’un support à un autre. La seconde partie de ce mémoire sera consacrée à la macrotypographie afin d’étudier dans quelle mesure la structuration d’une composition est porteuse de sens et induit des usages de lecture. Nous essaierons de mettre en évidence les outils de conception qui peuvent être une aide ou parfois une contrainte. Enfin, dans la dernière partie, nous nous intéresserons aux évolutions des espaces de lecture portés par le numérique.

LA LISIBILITÉ: LES ENJEUX

DE LA STRUCTURATION

DE LA LETTRE

-----

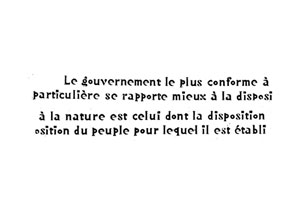

Le texte est considéré comme étant une suite de signes linguistiques ordonnée et régie par des règles

sémantiques et culturelles. C’est un outil de communication qui, inscrit sur un support, permet le partage et/ou l’archivage de données textualisées. Pour Roland Barthes le texte est d’abord le dessin de lettres qui forment «l’entrelacs d’un tissu» (le terme texte est apparu au XIIe siècle, il provient du latin texere qui signifie tisser). C’est la matérialisation d’un discours par une trace écrite qui garantit sa stabilité et sa durabilité. Elle est constituée d’un assemblage codifié et structuré de «forme-lettre» qui est à la racine du mot, de la phrase, du paragraphe. La structuration de cette marque ou empreinte écrite est la plus petite échelle du texte, c’est ce que l’on nomme microtypographie.

À travers cette première partie, nous allons interroger la lettre dans l’intention de comprendre comment sa forme et sa structuration participent à la lisibilité et au sens du texte. De plus, nous analyserons l’influence des techniques et des technologies sur les procédés de conception dans le but de saisir dans quelles mesures ils modifient les caractéristiques de la lisibilité.

La lettre, son sens, son image

La lettre, telle que nous la connaissons aujourd’hui, est le résultat d’un long processus d’innovations technologiques et de mutations techniques, et a pour origine la naissance de l’écriture en Mésopotamie à la fin du IVe millénaire av. J-C. Elle est un maillon qui, assemblé avec d’autres et inscrit sur un support, permet d’archiver et de transmettre la connaissance. Robert Massin, typographe et designer français, l’exprime ainsi: «La lettre est le véhicule de la communication imprimée. Noyée dans le mot, emportée par le flot de la lecture au fil des pages, effleurée du regard par des lecteurs pressés et avides, elle a pour mission essentielle de se faire remarquer le moins possible.» . La lettre, malgré sa nécessaire discrétion, a une utilité importante puisqu’elle a pour fonction première de donner à lire un texte, de communiquer par l’écrit un message. Elle participe à un écosystème constitué de mots, de phrases,de paragraphes qui doit être maîtrisé pour servir la lecture en donnant à voir et/ou à lire. C’est un ajustement équilibré, qui lie des zones d’espacement et de dessin de lettres, qui permet la bonne réception d’un texte.

Comme le souligne François Richaudeau dans son article «Une nouvelle formule de lisibilité» , quand nous lisons nous établissons une «dichotomie saussurienne».Chaque mot ou ensemble de mots est une combinaison complémentaire d’un signifié et d’un signifiant, autrement dit, d’un concept et d’un signe linguistique. Le signifié se rapporte au «concept correspondant à la signification du mot» , et le signifiant à la «représentation matérielle: image acoustique (en audition) ou visuelle (en lecture) de ce même mot» . Cette distinction propose deux images: l’image du mot formé par une police de caractères et l’image mentale de celui-ci. La signification ou connotation du dessin d’un caractère est déterminée par les cadres de représentation sociaux du lecteur, qui amène avec lui son expérience de la forme et de la lettre. La réception d’un caractère est déterminée par son contexte de création, par le contexte de son inscription et enfin par le bagage culturel du lecteur qui le réceptionne. Ce que nous explique Peter Bilak, designer graphique et typographe néerlandais: «[…] les fontes acquièrent du sens par l’usage seulement, et nous ne les jugeons pas uniquement sur la façon dont elles se réfèrent à nos expériences antérieures.» .

Le dessin d’un caractère tient, à la fois de la technique, en répondant à un certain nombre de règles et de critères qui participent à sa bonne lisibilité et/ou visibilité, mais aussi d’un aspect esthétique qui s’inscrit dans

un mouvement culturel et donne à sa courbe et à son trait une connotation, une expressivité qui participe au sens de la lecture. Pour Peter Bilak, la technique et l’esthétique doivent fonctionner ensemble et ne peuvent pas être dissociées, ni l’une de l’autre, ni de leur contexte: «Le dessin est un élément inséparable de la qualité des caractères, mais on doit également prendre leur fonction en considération. À travers la maitrise des proportions, l’équilibre et les corrections optiques, le typographe peut atteindre son but qu’il s’agisse d’améliorer la lisibilité, d’exactitude historique ou d’originalité d’expression.».

Parce que la lettre se donne d’abord à voir, elle ne peut être invisible, neutre et non-porteuse de sens. Elle doit former un juste équilibre entre la forme et le fond, dans le but premier de diffuser le discours du texte. Vivien Philizot, designer graphique et chercheur, nous explique dans un article pour la revue textimage qu’une composition que l’on qualifie de neutre n’est pas sans connotations et sans références. En effet, les polices de caractères tels que l’«Universal» d’Herbert Bayer, l’«Univers» d’Adrian Frutiger ou encore l’«helvetica» de Max Miedinger, classifiées comme étant des linéales, ne sont pas pour autant soustraites de leur inscription temporelle et de leurs connotations. Elles s’inscrivent dans une volonté de simplification de la lettre et se détachent des références formelles de l’écriture manuscrite.

Lorsqu’un typographe dessine une police de caractères ou encore lorsqu’un designer met en page un texte, c’est l’usage et les publics visés qui influencent la conception des formes. La lettre doit avant tout donner à lire et à être au service de la pratique de la lecture. Selon Vivien Philizot les formes ne doivent pas être pensées comme un système de valeur régi par des normes et conventions, mais dans une interrogation et une prise en compte du lecteur . En effet, le lecteur n’a nulle obligation de connaitre les connotations ou références historiques pour lire le contenu. Le texte prend toute sa place lorsque celui-ci est lu, c’est donc le lecteur qui lui donne du sens.

Entre lisible et visible

Le Centre National des Ressources Textuelles et Lexicales propose deux définitions possibles pour le mot «lisibilité». Il est d’abord défini comme étant le «Fait qu’une écriture, un texte imprimé soit facilement perçus lors de la lecture». Il est aussi défini ainsi: «Facilité de compréhension d’un texte».

La lisibilité d’un texte, sur papier ou sur écran, est un ajustement et une compréhension de l’ensemble des processus de lecture et des caractéristiques techniques et graphiques comprennant la composition de la page jusqu’au dessin de la lettre et permet une lecture aisée. Entre lisible et visible il y a une distinction d’usage à prendre en compte. Charles Peignot, fondeur de caractères français, propose une distinction entre le lire et le voir qu’il nomme «typo-lecture» et «typo-vision» . La «typo-lecture» correspond à l’utilisation de caractères destinés à la lecture de texte long et la «typo-vision» à la lecture de titrages ou phrases d’accroche.

Les caractères sont des outils de sens au service de la diffusion du texte. La distinction entre lisible et visible est importante, car elle n’implique pas les mêmes usages de la lettre ni les mêmes caractéristiques de dessin. Il est donc important de déterminer le contexte d’usage pour maitriser la réception d’un texte.

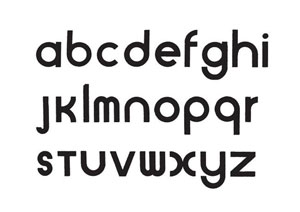

Police de caractères aux limites de la lisibilité

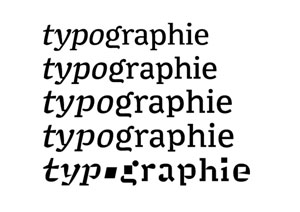

La lisibilité d’un caractère est liée à ses caractéristiques intrinsèques. Le support de son inscription ainsi que sa technologie de conception influencent les procédés de fabrication. Nous pouvons prendre l’exemple du caractère «Minuscule» dessiné par Thomas Huot- Marchand, designer graphique et typographe. C’est un caractère qui se base sur les travaux de Louis-Emil Javal sur la lisibilité et les systèmes de reconnaissance optique de la lecture. Cet ophtalmologue de la fin du XIXe siècle, considéré comme le père de l’orthoptie (dépistage et rééducation des troubles de la vision) avait pour volonté de comprendre les systèmes de lectures entre l’œil et le mot et de déterminer les facteurs de lisibilité d’une police de caractères. Il décide de faire ses recherches suite au constat que «depuis plus de trente siècles, les caractères employés par l’homme pour noter sa pensée ont évolué presque sans méthode, au gré des circonstances. Il en résulte que nos écritures modernes, depuis celle du jeune écolier jusqu’à la typographie la plus élégante, constituent une offense au bon sens et ne sont tolérées que grâce à la routine séculaire qui les transmet de génération en génération» . Ses expérimentations lui ont permis d’observer que la lisibilité était liée à la taille de la police de caractères et à l’espacement entre les lettres. Il fut aussi le premier à démontrer que la lecture ne se faisait pas par une reconnaissance lettre par lettre.— «le regard n’a pas le temps d’examiner chaque lettre» —, et que la lecture est une pratique qui ne se fait ni de manière fluide, ni de manière continue. Ainsi, l’œil balaye le texte ligne par ligne en effectuant des saccades, c’est-à-dire une alternance entre des temps de fixations et des temps de mouvements. Ce qui lui permet une reconnaissance d’un ensemble de caractères qui correspondent d’après Jost Hochuli à un ou deux mots pour la langue française .

Avec l’aide de Charles Dreyfuss, illustrateur et graphiste français, Louis Emil Javal met au point une police de caractères expérimentale qui questionne la lisibilité sur de petits corps. Cette police reste lisible jusqu’au corps 4, et son dessin exagère les caractéristiques visuelles de chaque lettre, ce qui permet une meilleure reconnaissance de chacune d’entre elles.

À partir de cette expérimentation, Thomas Huot-Marchand a décidé de concevoir une police de caractères qui a pour usage la lecture en très petit corps sur un support imprimé. Il explique dans une interview que pour chaque variation de taille de caractères un dessin différent a été nécessaire. En effet, plus l’image d’une lettre est petite, moins ses détails deviennent perceptibles. Pour contrer cette perte visuelle, il a dû expérimenter des formes qui se rapprochaient de la caricature. À travers cet exemple, ce qui nous intéresse est l’observation des formes dans le but de se confronter aux limites de la lisibilité et de la perception de l’œil humain. Dans ce projet, le dessin de caractères est influencé par les limites physiques de l’outil de vision de l’homme. La lisibilité sous influence technologique

Dans l’histoire du dessin de caractères, les typographes ont dû s’adapter aux technologies d’impression et de visualisation de polices. À chaque modification technologique, il a fallu créer ou ajuster les techniques et les procédés de dessin, ce qui amène à se demander dans quelles mesures la technologie contraint la conception de caractères. À cette question, Matthew Carter, typographe anglais, explique lors d’une conférence que la technologie influence la manière de concevoir, mais ne considère pas qu’elle soit une forme de contrainte.

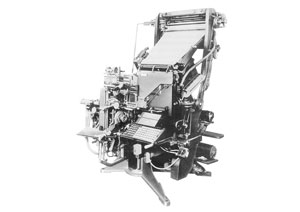

À travers deux polices de caractères qu’il a conçu, le «Bell Centenial» et le «Verdana», nous allons étudier comment la technologie transforme les procédés de conception et influence la lisibilité. Ce typographe a naturellement été choisi puisque tout au long de sa carrière, il a su développer un savoir technique spécifique grâce à sa capacité à s’adapter aux nouvelles technologies. Il a travaillé sur des machines de type Linotype , sur des technologies de photocomposition , et enfin sur des compositions typographiques numériques à l’aide d’ordinateur: «La technologie a évolué de nombreuses fois depuis mes débuts: la photo, le numérique, le bureau, l’écran, le Web. J’ai dû y survivre et essayer de comprendre leurs implications dans mon travail de conception» .

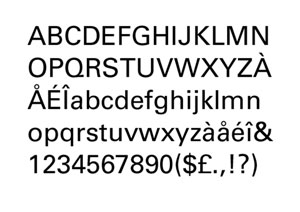

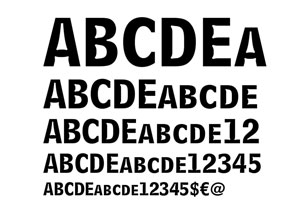

Police de caractères à usage de la lecture sur support imprimé

Matthew Carter, travaillant pour la Mergenthaler Linotype Company, dessina une police de caractères à l’usage des annuaires téléphoniques distribués par la société États-Unienne AT&T, à l’occasion des 100 ans de la société (American Telephone & Telegraph Company, l’opérateur historique américain fondé en 1885 et disparu en 2005). Le «Bell Centennial» , achevé en 1978, est une famille de polices de caractères sans empattement contenant quatre graisses: «Bell Centennial STD SubCaption», «Bell Centennial STD Adress», «Bell Centennial STD BoldListing» et «Bell Centennial STD NameAndNum». Cette société souhaitait modifier ses répertoires de polices de caractères. En effet le «Bell Gothic» (caractères sans-serif conçu par Chauncey H. Griffith en 1938) qu’elle utilisait pour son annuaire téléphonique n’était plus adapté à la nouvelle technique et technologie de photocomposition. Ce caractère réglé numériquement pour une impression offset ne s’adaptait pas aux nouvelles pratiques et créait des déformations de lettres lors de l’impression.

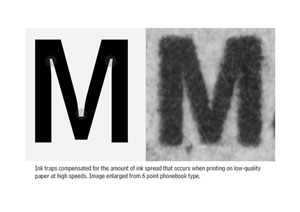

Le cahier des charges de la «Bell Centennial» était assez complexe, car il envisageait de devoir affronter et surmonter les limites de l’impression de l’annuaire téléphonique: un papier journal, une impression à haute vitesse avec une encre au kérosène et à la suie qui modifie le dessin des caractères en se propageant. Matthew Carter dira dans une conférence: «Ce n’est pas un environnement accueillant pour un concepteur de typographie. Le défi

fut donc de créer la police qui conviendrait le mieux à ces terribles conditions de production.»

La conception de la «Bell Centennial» a permis de réduire les coûts de fabrication en maitrisant les différents processus de créations, techniques et d’impression. Ce caractère avait pour but de rester lisible même en petit corps 6, ce qui a permis de diminuer la quantité de papier et d’encre utilisé.

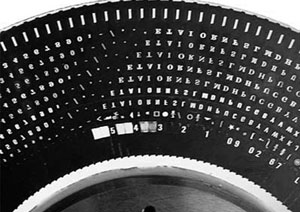

La nouvelle technologie de photocomposition a imposé à Matthew Carter une adaptation technique des processus de création: «C’était les prémices de la typographie numérique. Je devais dessiner tous les caractères à la main sur du papier millimétré.— Bell Centennial existait en 4 graisses.— pixel par pixel, puis les encoder trame par trame pour le clavier. Cela a pris deux ans, mais j’ai énormément appris» . Pour pallier au problème de propagation de l’encre sur le papier journal, Matthew Carter a mis au point un système de réserve dans le dessin de la lettre , dans le but de compenser les effets indésirables des procédés de production. «Les pixels évidés aux intersections des fûts ou aux angles sont le résultat de mon observation de l’influence de l’encre imprimée sur du papier bon marché» .

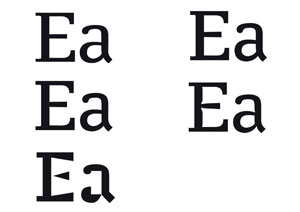

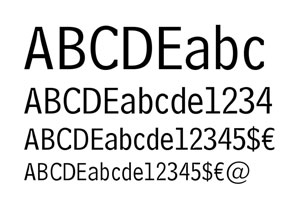

Le «Bell Centennial» est une police de caractère dont le dessin a pour objectif de mettre l’accent sur la différenciation entre les lettres, mais aussi entre lettres et chiffres. La compagnie AT&T avait proposé l’utilisation de la police de caractères Helvetica sans prendre en compte ses propriétés physiques, qui ne correspondaient pas aux critères de lisibilité d’un annuaire téléphonique. Matthew Carter a mis l’accent sur la distinction entre la lettre «l» minuscule et le chiffre «1», et entre la lettre «O» et le chiffre «0».

Le Bell Centennial est une Linéale: une lettre sans empattement, étroite, qui par son dessin propose des solutions techniques qui favorisent la lisibilité du caractère. On peut dire qu’elle est de conception robuste. Elle permet de gagner un espace non négligeable tout en restant lisible.

Ce premier exemple nous permet de comprendre qu’afin de rendre lisible une police de caractères, un typographe doit prêter attention aux contraintes de l’usage du caractère, mais aussi aux technologies qui imposent des transformations dans les processus de conception et à la création de nouvelles techniques de dessin.

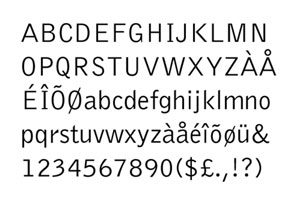

Polices de caractères à usage de la lecture sur support-écran

Les supports-écrans donnent un nouvel usage aux polices de caractères. En effet, l’écran d’ordinateur n’est plus seulement un outil de composition typographique avec pour finalité l’impression du contenu, mais une surface sur laquelle un texte peut être lu. À travers la police de caractères «Verdana», nous allons essayer de comprendre ce changement de statut, puis évaluer les changements techniques induits par cette nouvelle pratique de lecture apparue avec la généralisation des ordinateurs dans les années 80.

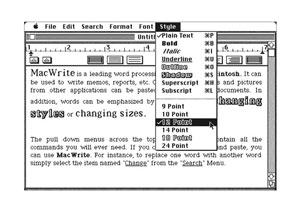

Les ordinateurs personnels au sein des foyers domestiques modifient l’usage des polices de caractères. Chacun peut composer son propre texte et voir immédiatement le résultat via des logiciels de type WYSIWYG “ What you see is what you get ”, ce qui signifie en français «ce que vous voyez est ce que vous obtenez». Ces outils proposent une interface utilisateur qui permet de concevoir une composition typographique et d’en avoir immédiatement le résultat sur un écran. Ce qui change est que l’usager n’a donc plus à utiliser un système d’instruction et de balisage du texte (non visible lorsque l’on imprime celui-ci) pour lui attribuer par exemple une graisse. De plus, chaque logiciel de traitement de texte ne possède plus leur propre système de codification.

Avec la généralisation des ordinateurs, les caractères ont désormais la nécessité de s’adapter et d’être compatibles avec la lecture sur écran. Les ordinateurs disposent de logiciels de traitement de texte comme «MacWrite», installé sur les premiers Macintosh de la marque Apple. Le micro-ordinateur, dont les performances dépassent celle de la photocomposition, transforme la pratique des designers. En effet, on peut numériquement créer des polices de caractères à l’usage de l’impression ou à l’usage de la lecture sur écran. Cette nouvelle pratique va simplifier le travail des typographes, il n’est donc plus nécessaire d’avoir un dessin par corps de caractères.

Les usages des polices de caractères se modifient et impliquent de nouveaux processus de création et de nouvelles contraintes. Chaque avancée technologique induit de nouvelles pratiques. Le typographe doit donc transformer ses outils de création dans le but d’optimiser le dessin d’une police de caractères. Matthew Carter nous explique qu’au début des micro-ordinateurs, la performance technologique influençait grandement les techniques de dessin de caractères. «À cette époque, il y avait un problème de taille des polices de caractères, et de quantité de données nécessaires pour trouver et stocker une police dans la mémoire d’un ordinateur. Le nombre de polices disponibles dans votre programme typographique était limité» .

Matthew Carter fut engagé par Microsoft au début des années 90 dans le but de dessiner une série de polices de caractères à l’usage de la lecture sur écran. Le but étant de concevoir plusieurs familles prenant en compte la matérialité et la performance des écrans pour contrer leurs problèmes de résolution et d’affichage. Jusqu’à cette période, les polices de caractères subissaient des adaptations qui ne prenaient pas en compte les faisabilités techniques et par conséquent, n’étaient pas réellement adaptées à ce support. La démarche de Microsoft était de concevoir des polices natives pour écrans, dessinées pour ce support. Avec l’aide de Thomas Rickner, typographe et designer américain, Matthew Carter dessina le «Verdana» en 1993. C’est une police de caractères sans empattement qui avait pour objectif d’être optimisée pour l’affichage-écran. En effet, avec la mauvaise résolution des premiers ordinateurs à écrans cathodiques, il était nécessaire de repenser le processus de dessin et d’envisager de nouvelles manières de rendre lisible un caractère. Simon Earnshaw, typographe travaillant pour Microsoft, explique que Matthew Carter entreprit, pour concevoir chaque lettre, non pas un dessin de la lettre par son contour, mais le système «bitmaps», c’est-à-dire une image numérique décrite point par point: «Bitmaps are relatively easy to make and they show exactly how the fonts will look on-screen. This allowed us to make decisions about sizes, weights, and distinctions between serif, sans, roman, italic, all viewed in context. Working this way we came up with a definition for a certain number of critical sizes and weights.» . Il utilisa le même système d’appréciation de la lisibilité que l’imprimeur Anisson qui fit imprimer un même texte en police de caractère Garamond et en Didot: “[...] we would set a paragraph of text in a pre-existing face and in Verdana on the same screen. Then we would walk backwards across the room until one of them became illegible.”

La matérialité même du support du caractère «Verdana» a contraint Matthew Carter à créer des ajustements optiques sur certaines ligatures telles que le «fi» «fl» et «ff», à cause de mauvaises conditions de lisibilité sur écran. La solution trouvée a été de faire en sorte que ces combinaisons ne se touchent pas. Le «Verdana» se caractérise donc par une «hauteur de x» importante et par de larges proportions avec un faible contraste. Le dessin de chaque lettre a été optimisé dans le but d’éviter toute confusion de forme comme par exemple la lettre minuscule «i», qui est dessinée légèrement plus courte que la lettre «l».

Les enjeux de la lisibilité sur écran

Les systèmes d’exploitation, les navigateurs ou encore les différents types d’écrans transforment nos usages de lecture, notre gestuelle et renouvellent les critères et les facteurs de la lisibilité. La première difficulté lorsque l’on crée un contenu dédié à l’écran est de dompter complètement le rendu final à cause des contraintes techniques. En effet, la grande variété de tailles et de formes d’écrans et/ou de paramétrages des navigateurs

(la taille par défaut des polices de caractères), ou encore des couleurs, rend difficile la maitrise complète des compositions typographiques sur écran. De plus, le texte n’est plus stable comme sur une édition papier. Il est inséré dans des blocs de proportion prédéfinis que l’utilisateur peut redimensionner en changeant soit de support, soit de taille de fenêtre. Ceci a pour conséquence un rétrécissement ou une augmentation du nombre de mots par ligne. L’adaptation des règles typographiques sur écran est de plus en plus maitrisée grâce au HTML5 , comme c’est le cas par exemple pour les espaces fines ou encore les césures. Le designer doit mettre en place des stratégies de conception par le langage de programmation dans le but d’anticiper les qualités et proportions d’affichage des différents environnements de lecture, ce que souligne Olivier Reichenstein: “Control over typography is not just a basic design necessity, knowing how to treat text as a user interface is the key factor for successful Web design” . En effet, il est important de maîtriser l’ensemble des dispositifs structurants pour rendre la lecture lisible sur un écran. Il faut maîtriser l’interlignage, le corps, la graisse de la police de caractères, les espaces mots et fine, ainsi que le contraste. Ces paramètres sont liés à la distance de lecture entre l’œil de l’usager et la surface éclairée de l’écran, mais aussi à la matérialité des surfaces technologiques qui ne réfléchissent pas la lumière de la même manière que le papier.

Contrairement aux tablettes ou écrans d’ordinateur qui sont multi-usages et utilisent un système de rétroéclairage, les appareils de type «liseuse», proposent un dispositif uniquement orienté sur la lecture. L’utilisation de l’encre électronique permet une lecture moins fatigante et agressive pour l’œil humain, en proposant un contraste et une luminosité adaptés à la lecture de texte long. Pour ce qui est de la nécessité d’utiliser des polices de caractères spécifiquement dessinées pour l’écran, ce paramètre peut être aujourd’hui remis en question avec l’augmentation continuelle de la résolution de l’affichage. Les écrans «retina» développés par Samsung Electronics en sont un bon exemple: ils proposent une résolution constituée d’une forte densité de pixels afin que l’œil humain ne soit pas en capacité de discerner ou de constater la pixellisation des contenus iconographiques et/ou textuels. Ce développement de technologie remet en question la nécessité d’une police de caractères pour un usage spécifique à l’écran.

À travers cette partie, a été interrogé l’échelle microtypographique, l’ensemble des caractères pouvant composer un mot, une phrase, un paragraphe ou un texte, afin de comprendre comment leurs structurations sont influencées par la technologie de leur support d’inscription, et comment ils participent à la lisibilité et au sens du texte. Le dessin d’une police répond à des exigences techniques, mais aussi esthétiques, régies par des caractéristiques optiques, structurelles et de lisibilités qui doivent être adaptées au contexte de leurs usages. Cette structure typographique presque invisible conditionne et oriente la pratique de la lecture, comme l’usage de la ponctuation, ensemble de signes graphiques définissant les liens sémantiques entre différents éléments, donnant une logique et un sens à la lecture.

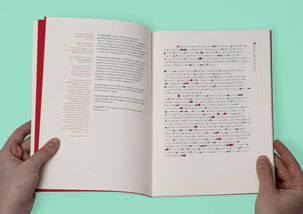

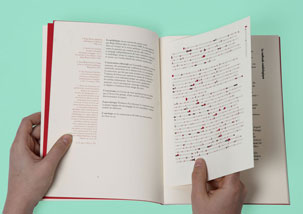

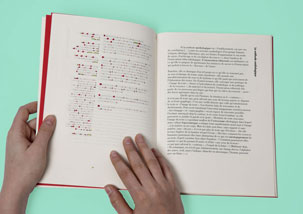

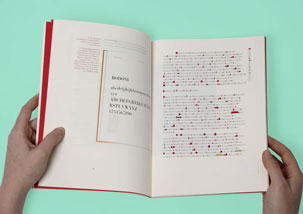

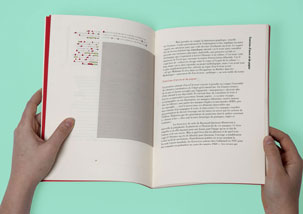

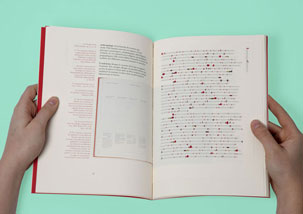

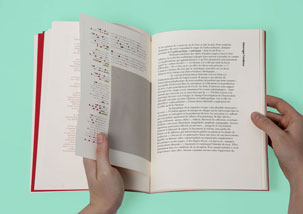

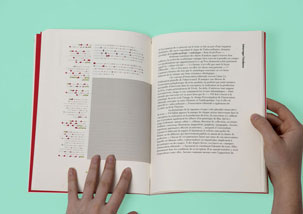

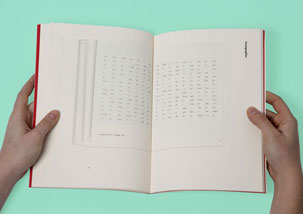

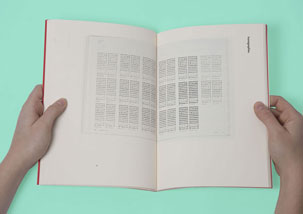

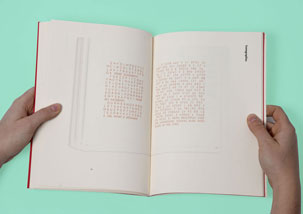

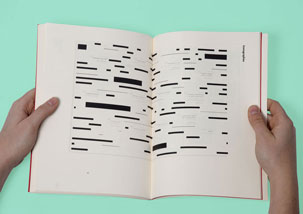

Dans le cadre d’un cours «édition et iconographie» , nous avons été invités à réfléchir et expérimenter sur l’importance de la typographie et sur la relation texte/image à travers la mise en page du texte d’Emmanuël Souchier «L’image du texte pour une théorie de l’énonciation éditoriale» .

La conception de cette édition a été l’occasion de réfléchir à l’influence et à l’importance de la maitrise de l’ensemble des éléments structurants d’un texte. Interroger ce que nomme Emmanuël Souchier «texte second» m’a permis d’examiner et de comprendre les notions de gris typographique et d’architecture de la microtypographie en proposant une double lecture de cet article. En effet, par-dessus la composition du texte, est juxtaposée une cartographie typographique, un système codifié qui utilise des rectangles colorés dans le but de proposer une classification et une mise en avant de l’ossature du texte. Elle révèle la forme des mots, les espaces fines, les espaces mots, les chiffres et la ponctuation, soit un ensemble d’éléments quasi invisibles aux yeux des lecteurs, et qui pourtant doit être maîtrisé par le designer dans le but de rendre le texte lisible et compréhensible.

Cette expérimentation a été l’occasion d’une première prise de conscience de l’importance de la microtypographie dans sa forme et sa structure. Ce projet m’a amené à réfléchir plus en profondeur à la structure de l’image d’un texte et à l’importance des polices de caractères.

Comme nous l’avons vu à travers cette première partie, la composition typographique d’un texte est influencée par un ensemble de facteurs qui doivent être interrogés dans le but de maîtriser le sens de l’image du texte. Questionner l’usage et le contexte d’usage d’une police de caractères permet une meilleure compréhension des enjeux de la structuration microtypographique.

LES ENJEUX DE LA STRUCTURATION

DU TEXTE NUMÉRIQUE

-----

L’écran est un objet technologique basé sur le calcul proposant de par sa matérialité un environnement réinscriptible et non figée, c’està-dire, qu’il donne la capacité à l’usager de pouvoir consulter et modifier le texte en tout temps.

«L’énonciation éditoriale», notion développée par Emmanuël Souchier, se modifie par les modalités d’accès et les processus d’inscription du texte. En effet, nous pouvons dire que c’est l’ensemble de la chaine éditoriale qui est modifié par le changement de statut de l’auteur, de l’éditeur et du lecteur face aux écrits d’écran. Les actions d’archiver, d’éditer, de publier ou encore de diffuser ont changé de nature puisque l’auteur devient «multi acteur». Il peut être à la fois éditeur, lecteur, contributeur, développeur, etc. Cette multiplication de fonction nécessite une assimilation des technologies de ce support qui force tout auteur à saisir et assimiler les normes, les codes, mais aussi un savoir-faire propre au numérique.

Le texte placé sur un environnement-écran devient un programme ou encore un «architexte» . Autrement dit, par la matérialité des «médias informatisés» le texte devient «un écrit d’écrit», un fichier texte constitué d’un ensemble d’instructions qui permet la formalisation de celui-ci à l’écran. Ce dispositif d’inscription modifie profondément les processus éditoriaux d’édition. Le texte prend d’autres formes et se détache de la culture du livre comme l’évoquent Yves Jeanneret et Emmanuël Souchier dans leur article «L’énonciation éditoriale dans les écrits d’écran»: «[…] l’écran n’est pas un simple support de signes, c’est aussi, et surtout peut-être, un lieu où les signes trouvent leur forme et leur organisation.»

L’usager, la matérialité du support ainsi que les nouvelles formes standard de l’édition numérique modifient profondément les manières d’envisager le texte. C’est toute la macrotypographie qui se transforme, c’est-à-dire, l’ensemble des éléments visibles ou non visibles qui participent à l’organisation, à la hiérarchisation d’un texte, par exemple les titres, les sous-titres, les types de paragraphes, etc.

Dans cette partie, nous nous interrogerons sur les mutations des dispositifs typographiques qui structurent une composition textuelle. Nous examinerons aussi, dans quelle mesure la macrotypographie participe à la compréhension et à la lisibilité d’un contenu.

LA GRILLE TYPOGRAPHIQUE

«Il [le typographe] doit inlassablement parfaire son sens des proportions, afin de pouvoir juger sans défaillance

de la portée et de la limite d’un rapport de proportions.

Il sentira alors à quel moment la tension établie entre deux éléments devient si forte que l’harmonie se trouve menacée. Il apprendra à éviter les rapports sans tension aucune qui engendrent l’uniformité et l’ennui. Il déterminera en outre le degré de tension plus ou moins fort qui devra exister selon la nature et le caractère de l’ouvrage qui lui est confié. On ne peut donc concevoir un principe de calcul rigide, comme le rapport de la règle d’or 3:5 ou 8:13, pour un autre.»

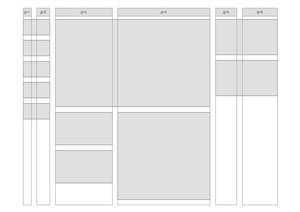

La grille typographique est le fruit de la culture de l’imprimé. C’est un système de classification composé d’axes verticaux et horizontaux qui participe à la structuration d’un contenu. C’est une tentative de rationaliser, d’ordonnancer et de structurer la mise en page typographique. Elle divise une page verticalement et horizontalement en créant des zones dédiées grâce à l’agencement de marges, de colonnes, de gouttières, etc. Toutes ces divisions forment des ensembles modulaires qui systématisent la composition typographique d’une conception éditoriale. Ce processus est un outil, une aide à la conception qui participe à la cohérence de l’ensemble des pages du projet.

Müller Brockmann, designer graphique suisse, est considéré comme le père du système de la grille typographique. Il souhaitait à travers ce procédé ordonnancer les rapports entre le texte et l’image en analysant leurs propriétés respectives. Il considérait la notion d’ordre comme étant la maîtrise de la somme des caractéristiques de la lisibilité et la compréhension des rapports entre formes: “The formal organisation of the surface by means of the grid, a knowledge of the rules that govern legibility (line length, word and letter spacing and so on) and the meaningful use of colour are among the tools a designer must master in order to complete his or her task in a rational and economic matter.” . La grille est un outil, une méthode d’organisation qui permet de créer une logique et une harmonie au sein d’une composition graphique.

Les enjeux de la flexibilité de la grille

L’écran a transformé cet outil dans le but de l’adapter aux contraintes techniques et technologiques de ce support, mais aussi pour accompagner les pratiques de lecture numérique. Mullër Brockmann, dans son ouvrage “Grid Systems in Graphic Design” explique que la conception d’une grille sur un support imprimé implique de prendre en compte les proportions de la page, soit, ses limites physiques. Or, la page numérique ne peut pas avoir de proportions fixes ou standardisées à cause du grand nombre d’appareils et de formes d’écrans. La définition d’une page papier ou numérique ne dispose pas des mêmes caractéristiques. Une page imprimée propose un format dit «absolu» avec des limites fixes alors qu’une page-écran propose un format dit «relatif», c’est-à-dire qui n’est pas fixe et qui peut être transformé, redimensionné. La multiplication des formats-écrans oblige le contenu à une grande flexibilité et à des qualités adaptatives. Alors qu’auparavant on pouvait imaginer faire une version d’un site pour chaque type d’appareil, aujourd’hui les langages de programmation permettent de produire un site unique avec un contenu souple et modulable. Concevoir un site pour chaque type de plateforme n’est pas non avenu, mais plutôt contraignant dans une démarche de pérennisation et d’actualisation des contenus. C’est Ethan Marcotte, Web Designer indépendant qui développa le premier la notion de “responsive design” (en français conception adaptative). Par l’expression “responsive design” , il désigne un processus de conception éditoriale numérique qui propose une optimisation de la lecture et de la navigation, quel que soit le type de format, le type de navigateur ou encore le type de système d’exploitation. C’est un principe basé sur un redimensionnement du contenu adapté à la taille de l’écran et à sa gestuelle. C’est une réflexion qui propose de nouveaux modèles qui modifient les comportements de la micro et macrotypographie dans le dessein de prendre en compte l’usager et son contexte de lecture.

Il est important de prendre en compte les contraintes d’inscription et de diffusion d’un texte numérique. Pour cela, les systèmes de conceptions éditoriaux hérités par l’imprimé devraient être repensés. Mark Boulton, designer graphique anglais propose, pour la conception d’une page-écran de se concentrer non pas sur les dimensions des «canvas» (élément de programmation html5 qui permet de créer un espace de génération pour des formes, des images ou du texte), mais plutôt sur un élément de contenu qui donnera les proportions de l’espace de la page: «Pour concevoir des designs réellement adaptés au web – quel que soit l’appareil – nous devons nous débarrasser de l’idée que nous créons des mises en page pour un canvas donné. Nous devons aborder le problème dans l’autre sens, et créer des mises en page à partir de leur contenu» . En effet, en plus de penser la relation entre le fond et la forme du contenu, il est impératif de prendre en compte le support numérique qui implique à la fois des compétences techniques par un apprentissage des langages de programmation, mais aussi une connaissance des usages et des pratiques de lecture.

L’expérience utilisateur est un concept définit par Donald Norman, directeur du Design Lab de l’Université de Californie, et adoptée comme standard par “International Organization for Standardization” (Organisation internationale de normalisation), qui engage un designer à réfléchir «aux perceptions d’une personne qui résultent de l’usage ou de l’anticipation de l’usage d’un produit, d’un service ou d’un système» . Autrement dit, c’est prendre en compte les comportements de l’utilisateur dans le but de créer des interfaces intuitives et intelligibles, qui répondent donc à des critères d’ergonomie . Cette approche modifie la manière de penser la conception en positionnant l’utilisateur au centre de la réflexion et en essayant de décrypter ses habitudes et ses attentes. Stéphane Vial, dans son ouvrage Court traité du design, propose cette définition: «[C’est] un design qui se vit, qui s’éprouve, s’expérimente. L’utilisateur en ressent immédiatement l’effet parce que son expérience s’en trouve instantanément transformée, améliorée, augmentée.» . Les principes de conception sont déplacés, ils ne sont plus axés sur les liens entre le fond, la forme et le support, mais sur le design graphique et la technique d’inscription du contenu sur son support. Ce concept propose de réfléchir d’abord aux questions à résoudre (à des besoins) dans le but de déterminer les différents moyens à mettre en place pour y répondre avant de faire des propositions de design graphiques.

Créer une grille typographique numérique fluide, c’est imposer un comportement souple à l’ensemble des éléments d’une page et prendre en considération l’usager ainsi que la multiplicité des environnements de réception de ce contenu.

La grille a ratio irrationnel

La grille est un outil, qui comme expliqué précédemment sert à ordonnancer le contenu par un dispositif organisateur qui guide la conception éditoriale. Nous avons aussi évoqué le fait que la matérialité de la page induit des processus et des comportements de grille différents de l’imprimé. Nathan Ford dans son article “content-out layout” s’interroge sur la pratique de la grille et propose de questionner son système de colonages à proportion égale dite à «ratio rationnel». Pour lui, la grille «classique» est ennuyeuse: “Columns are boring” . Il propose, dans l’intention de dynamiser le contenu, de concevoir et d’expérimenter d’autres manières de l’envisager, l’usage d’un «ratio irrationnel». Sa méthode propose pour construire une échelle de proportion «irrationnelle» de se baser sur la taille de la police de caractère du texte courant et de créer des colonnes de largeur différentes, en utilisant le nombre d’or pour en déterminer les dimensions.

Nathan Ford propose donc une grille à «ratio irrationnel» qui permet, par la composition de ses colonnes, d’envisager les relations hiérarchiques du contenu. Nous ne sommes plus dans une grille aux proportions égales où viennent se juxtaposer les différents éléments de la page, mais dans un système qui prend pour point de départ le contenu. Ce n’est plus le contenu qui s’adapte à la grille, mais la grille qui s’adapte aux besoins du contenu: “we can arrive at a grid that accommodates our content needs.”

La grille et les dogmes

La grille typographique a pour usage l’aide à la structuration d’un contenu imprimé ou numérique. C’est un outil de conception et d’organisation qui est le témoin et la trace des différentes manières d’envisager la composition typographique. Elle est une source d’interrogation et de débat sur la pratique du design graphique.

Nous pouvons évoquer le débat entre Max Bill, architecte et théoricien de l’art suisse et Jan Tschichold, designer et typographe allemand. Celui-ci débuta en 1945 lorsque Jan Tshichold tint une conférence à Zurich où il annonça son changement de point de vue graphique, qui, jusque-là prônait les qualités de ce que l’on nomme la «typographie moderne». C’est un mouvement qui se positionne contre les pratiques de la typographie de la fin du XIXe siècle, c’est-à-dire, une typographie chargée de valeurs historiques, de symétries et d’ornementations. La nouvelle typographie, quant à elle, émerge dans les années 20 et a pour volonté de proposer un modèle de composition asymétrique, tout en évitant les ornementations. Jan Tschichold, dans son ouvrage «Typographische Gestaltung» en 1935, fait un parallèle entre la nouvelle typographie et le mouvement artistique «l’art concret» qui se différencie de l’art abstrait en basant sa pratique sur les lignes, les surfaces et les couleurs, qui mettent en avant une géométrie claire. «Les œuvres de la peinture concrète sont les symboles de l’organisation spatiale subtile à partir d’éléments simples et contrastants. Parce que la nouvelle typographie ne se donne d’autre mission que celle d’ordonner de telles structures, bien des œuvres de l’art concret peuvent fournir au typographe, en conception graphique, des modèles d’impulsion essentielle et véhiculer la diversité des formes optiques contemporaines.» . Avec l’arrivée au pouvoir d’Hitler et la réquisition de la typographie moderne en faveur de la propagande nazie, il décida de changer son approche. C’est ce revirement que Max Bill va remettre en question et critiquer hardiment dans un article nommé «de la typographie» publié dans la revue Schweizer Graphische Mitteilungern.

À travers ce débat, ce qu’il semble important de retenir est le fait que Jan Tschichold ne semble pas prôner un style de grille typographique comme un dogme, un système radical sans doute possible: «Ce qui me désole avant tout, écrit-il, c’est que [Max Bill] paraisse me contester le droit de créer selon mon bon plaisir. En tant qu’artiste, il devrait savoir qu’aucun esprit créateur ne peut créer autrement que dans le fil de ce qu’il tient pour juste.» . Il réfléchit et interroge sa pratique quitte à changer d’avis, ce qu’il fit plusieurs fois durant sa carrière. Le design graphique s’inscrit dans un environnement influencé par des mouvements culturels, économiques et sociaux qui doivent être une source d’interrogation dans l’intention de ne pas transformer des outils en dogmes radicaux.

La grille typographique n’est ni une règle absolue, ni une vérité universelle, ni un dogme incontestable et intangible. Toute composition typographique symétrique, asymétrique ou autre, qu’elle soit accompagnée d’une grille influencée par le format d’une page ou d’une grille flexible pour l’écran, se doit de questionner son contexte et son usage dans le but d’être au service de la compréhension du contenu diffusé. Ce que dit Jost Hochuli: «Symétrie ou asymétrie en tant que telle ne doivent pas être reprises au nom d’une vision du monde, d’une idéologie [et le] faire revient à se vautrer face contre terre et à se rendre ridicule»

Penser les liens entre le contenu et les formes

Le fond, la forme, le format et le support entretiennent des liens qui s’influencent mutuellement et produisent du sens. Le format d’une édition, l’image du texte, l’image de la lettre participent à la compréhension, à la signification et à la réception de l’ouvrage. Un texte est composé d’une structure qui donne à voir son organisation, l’orientation spatiale par un agencement structurel de l’ensemble des éléments qui le composent. Cette mise en page porte en

elle une fonction expressive qui donne une première image, une première lecture qui participe à la construction de la signification du contenu. Structurés et ordonnancés, les formats et les formes sont des dispositifs codifiés qui permettent de définir la pratique de lecture proposée. Il est intéressant d’analyser les transformations de ces

codes à travers un changement de support.

La culture de l’imprimé nous a appris à reconnaitre un contenu par son format et par un ensemble d’éléments qui informent et prolongent le texte. Nous pouvons nous interroger sur le déplacement des dispositifs de reconnaissance d’un contenu sur un support numérique et nous demander dans quelle mesure, comme le dit Roger Chartier dans son article «l’avenir numérique du livre», les écrans rompent avec la culture des formats du livre: «c’est la même surface illuminée de l’écran de l’ordinateur qui donne à lire les textes, tous les textes, quels que soient leurs genres ou leurs fonctions. Est ainsi rompue la relation qui, dans toutes les cultures écrites antérieures, liait étroitement les objets, les genres et les usages. C’est cette relation qui organise les différences immédiatement perçues entre les différents types de publications imprimées et les attentes de leurs lecteurs, guidés dans l’ordre ou le désordre des discours par la matérialité même des objets qui les portent.» . Pour Roger Chartier la mutation du numérique réside dans le fait que les textes ne sont plus inscrits dans des objets qui permettent de les classifier, de les hiérarchiser ou encore de les reconnaitre. La première observation que nous pouvons faire est que les écrans ont modifié notre système de reconnaissance du contenu. En effet, les textes ne sont plus inscrits dans des formats séparés physiquement aux dimensions mesurables, mais bel et bien inscrits sur une même surface. La reconnaissance du contexte et des cadres qui entourent le texte se voit modifiée par la matérialité même du support d’inscription. Lire un document imprimé et lire un document numérique n’implique pas la même gestuelle, la même gestion de l’espace, ni les mêmes éléments accompagnateurs du texte. De plus, en fonction du type d’appareil (téléphone, tablette, ordinateur) le contenu peut être modifié dans le but de servir les usages de celui-ci. Par exemple le journal anglais “The Guardian” qui met a disposition un journal imprimé, un site web, une plateforme “ GuardianWitness” et une application pour tablette et mobile (iOS et Android). À travers leur ligne éditoriale, on peut observer la prise en compte de la matérialité du support et l’adaptation du contenu en leur affectant des usages différents. La tablette et le téléphone partagent une application basée sur le journal papier qui s’adapte aux comportements et habitudes du lecteur, en leur donnant accès à un contenu personnalisé. La plateforme “GuardianWitness” propose aux lecteurs un espace de partage social du contenu. Des dossiers thématiques sont soumis aux usagers afin qu’ils enrichissent ces dossiers en apportant leurs propres images, vidéos et textes. Enfin, leur site internet permet une visibilité numérique qui invite le lecteur à acquérir un abonnement en donnant à lire un échantillonnage d’articles du journal. Les contenus ne sont plus inscrits dans des formats, mais dans des types de sites par exemple des blogs, des sites vitrines, des applications, des sites de e-commerce, des sites communautaires. Ces «formes modèles» sont des systèmes mis en place par des logiciels de traitement du contenu qui, par leurs dispositifs techniques, déterminent des formes et induisent des pratiques de lecture différentes.

Les CMS (les Systèmes de Management de Contenu) proposent des outils standardisés sous forme de menu qui conditionnent le texte, les images, les liens. Le but de ces logiciels est de faciliter la publication éditoriale numérique en proposant une interface d’inscription du contenu sans passer par une phase de programmation. Tout comme la grille, les CMS sont des outils d’aide à la conception graphique qui ne sont pas des règles absolues du comportement du contenu. Or, les CMS peuvent parfois contraindre les usagers qui n’ont pas une culture des langages de programmation lors de leur conception éditoriale. En effet, les CMS proposent des systèmes de grilles typographiques avec des usages liés aux types de sites que l’usager souhaite concevoir, or, ces grilles sont construites en dehors de la connaissance du contenu et peuvent donc provoquer des incohérences entre le fond et la forme. Nous pouvons prendre l’exemple des revues en ligne en science sociale diffusées par le biais du CMS de revues.org. Il propose un dispositif standardisé dans le but de diffuser numériquement l’ensemble des articles d’une revue. D’une revue à une autre, il n’y a aucune différence structurelle ni organisationnelle entre chaque entité. Les différences notables sont d’ordre esthétique: le choix d’un cadre coloré ou l’insertion d’un logotype. Il semble que le problème que peut poser un CMS est la trop grande standardisation des formes et le manque de liberté au niveau de la conception éditoriale. En effet, par l’usage de formes modèles, le concepteur utilise cet outil comme un système automatique de génération de formes et de structures, et oublie les stratégies et les liens porteurs de sens qu’entretiennent le fond, la forme et le support.

Les CMS sont des outils intéressants, mais qui nécessitent une connaissance en langage de programmation pour pouvoir personnaliser et enrichir les typologies de formes de contenu et ainsi concevoir des éditions avec une réflexion sur les usages et les enjeux de la diffusion numérique.

Organiser les contenus d’un texte:

penser la relation entre les éléments

et leur manipulation

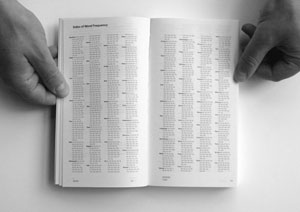

La structuration d’un contenu imprimé ou numérique a pour usage de saisir rapidement l’organisation et la navigation au sein d’une page ou d’un ensemble de pages. C’est ce qui est nommé l’architecture de l’information. Cette notion désigne la création d’un système de catégorisation qui permet la formation d’une structure rationnelle et ordonnée. Elle a pour but d’articuler hiérarchiquement l’ensemble des éléments formant le contenu. C’est un champ spécifique du design graphique que l’on nomme le design d’information. Ce terme apparait, d’après Robin Kinross , vers la fin des années 70, avec pour objectif «d’appliquer la recherche et la réflexion à la réalisation de produits et de systèmes.» . L’intention d’une recherche théorique sur la structuration de l’information était de penser la typographie de manière rationnelle et fonctionnelle en mettant en avant la lisibilité des caractères et l’ordonnancement structuré de la composition typographique au service de l’intelligibilité du contenu. Gui Bonsiepe, théoricien allemand, professeur à l’école d’Ulm, pense le design comme un outil cognitif, qui sous l’usage du dessin participe à la compréhension des processus mentaux qui se rapportent à la fonction de la connaissance: par exemple la mémoire, le langage, le raisonnement. Pour lui, «dessiner signifie créer de l’ordre, trouver une structure au sein d’un monceau d’objets ou de signes, réduire le désordre et disposer les éléments en un tout qui soit compréhensible.». Dans son article «Théorie de l’information et structures typographiques» , il pose les bases de ce qui sera le design d’information en faisant le rapprochement entre les mathématiques et l’esthétique des formes. Il explique que les formes peuvent être contrôlées, rationalisées, codifiées dans le but de maitriser le langage sémantique: «fournir au < design > une série de règles pour la création consciente et contrôlée des formes, plutôt que comme une source d’explication des phénomènes esthétiques». La maitrise des formes permet de définir les liens, les rapports, les usages, qu’entretient chaque élément constituant une composition typographique. Gui Bonsiepe définit deux types d’ordre: le premier consiste en «l’ordre des systèmes» , c’est la définition formelle des titres, des types de paragraphes, la pagination, le contenu iconographique, etc. de manière hiérarchique en prenant en compte l’usage et la fréquence de répétition. Le but étant de mesurer l’importance de chaque élément. Le deuxième type est «L’ordre de la configuration» c’est-à-dire, définir les liens corrélatifs entre chaque élément de «l’ordre des systèmes». Andrew Blauvelt, designer graphique et conservateur du Walker Art Center de Minneapolis, nous explique dans son article “Towards Relational Design” que dans les années 60-70 le design graphique se transforme et affirme une réflexion forte sur le lien qu’entretient le fond avec la forme. Cette évolution de pensée avait pour volonté de maîtriser le message de la forme en lui insérant des connotations fonctionnelles et culturelles. Le modèle de pensée du design s’enrichit dans les années 90 en prenant en compte l’usager et les nouveaux supports de diffusion.

La diffusion d’un contenu imprimé ou numérique n’implique pas les mêmes pratiques de lecture. La structuration du contenu se voit modifiée et adaptée aux pratiques numériques. Un livre propose une lecture dite «linéaire», une lecture en continu qui invite le lecteur à une attention tournée vers la lecture intégrale et chronologique du contenu. Alors que La diffusion d’un contenu numérique propose par son dispositif d’hyperliens une lecture que l’on peut qualifier de segmentée, comme nous l’expliquent Cédric Biagini, essayiste et journaliste et Guillaume Carnino, enseignant chercheur et ingénieur en informatique:

«le numérique, < hypertexte > et multimédia, induit une < hyper-attention > que des psychologues américains opposent à la < deep attention > (l’attention profonde) que nécessite la lecture linéaire sur papier» . Les contextes de lecture se modifient avec les appareils mobiles qui favorisent une lecture séquentielle et sélective. Tout comme nous pouvons différencier un journal d’un roman par son usage, sa pratique de lecture et enfin par sa structure, nous différencions sur support numérique la consultation d’un journal à celle d’un blog. La contextualité d’un contenu oriente son organisation et ses éléments de paratexte . Le paratexte est une notion développée par Gérard Genette dans son ouvrage Seuils publié en 1987. Il y définit l’ensemble des éléments qui accompagnent, informent et prolongent un texte: par exemple les titres, les notes de bas de page, la pagination, les renvois, etc.

«Un certain nombre de productions, verbales ou non, comme un nom d’auteur, un titre, une préface, des illustrations, dont on ne sait pas toujours si elles appartiennent [au texte], mais qui en tout cas l’entourent et le prolongent.» Ainsi, le paratexte est un dispositif qui permet d’informer sur le texte. Il est un lieu de passage entre l’intérieur et l’extérieur du texte. Par exemple, la première de couverture est un espace extérieur qui informe sur le texte par le titre, le nom, de l’auteur, l’éditeur ou encore la préface, indicant à l’usager ce qu’il va lire. Le paratexte est l’ensemble des marques que l’éditeur et l’auteur proposent, qui structure l’édition et transforme un texte en un objet reconnaissable. Nous pouvons nous demander comment ces éléments évoluent sur un écran. En effet, le paratexte se transforme et a la possibilité de s’inscrire dans un réseau par la création de liens hypertextes. La frontière entre texte et paratexte change, les limites ne sont plus imperméables. Nous ne sommes plus dans une logique d’intérieure ou d’extérieure du texte informant uniquement sur celui. Il peut proposer à tout moment des liaisons qui emmèneront l’usager vers d’autres contenus.

La structuration au service

de l’intelligibilité web

Nous pouvons distinguer deux types d’éléments structurant une page numérique: les liens hypertextes et l’espace sémantique du texte. Les hypertextes ont été prédits dans l’article “As We May Think” paru en 1945 dans le magazine Atlantic Monthly de l’ingénieur Vannevar Bush, et conçus par Ted Nelson, sociologue américain, pionnier de l’histoire des technologies de l’information. Les liens hypertextes font partie du paratexte numérique, c’est un dispositif qui permet de passer d’un «nœud» à un autre par l’activation d’un sélecteur. Autrement dit, c’est la possibilité de passer d’un contenu à un autre, lié par un clic de souris. Les liens sont des éléments qui organisent, contraignent, orientent et informent de manière non linéaire la navigation et la pratique de lecture au sein d’une page. En effet, ils proposent en cours de lecture de faire des choix qui offrent la possibilité de personnaliser le cheminement de lecture, dans le but de répondre au besoin d’information de l’usager. Les éléments de structure de navigation sont des éléments clefs renseignant sur le type de lecture proposé, ils sont des marqueurs d’usage. Ils peuvent être de différentes natures: informationnelle comme les notes de bas de page ou les mots clefs, structurante comme les menus de navigation, ou encore externe en proposant une liaison avec un contenu situé

en dehors du document numérique consulté.

L’espace sémantique numérique est le dispositif de structuration qui organise l’ensemble des données selon leurs sens et leurs usages.

C’est un système développé par le Word Wide Web Consortium (W3C) qui propose un protocole pour partager et rendre compréhensible des données. C’est l’échafaudage du contenu qui participe à la création du sens en proposant une hiérarchisation. Nous pouvons appliquer à une page numérique la théorie des procédés psychologiques de compréhension du discours du linguiste néerlandais Teun A. Van Dijk. et de son associé Walter Kinstsch , professeur de psychologie à l’Université du Colorado de Boulder aux États-Unis. Les deux chercheurs proposent deux types d’échelles de compréhension participant à l’espace sémantique. La première est la «macrostructure», la représentation schématique, cartographique du fonctionnement d’un texte. La seconde échelle est la «microstructure», la formalisation de la hiérarchisation du contenu. Ces deux échelles de la sémantique participent à ordonnancer et rendre accessible un contenu, à la fois en participant à la structuration de la lecture, mais aussi en intégrant ce contenu dans le maillage du réseau permettant de créer des bases de données et de mettre en liens les contenus.

La lecture sur un support numérique implique un apprentissage et la mobilisation d’expériences antérieures pour traduire l’ensemble des codifications structurelles tels que les titres, les menus «hamburger», les liens structurants. La compréhension schématique de l’ensemble d’un site internet ou d'un contenu sur support numérique dépend de l’expérience de l’usager, mais aussi de la pertinence de la structuration sémantique et hypertextuelle

Comme le dit Oliver Reichenstein dans son article “Web Design is 95 % Typography” “Treat Text as a User Interface” (considérez le texte comme une interface utilisateur) le texte devient un espace d’interaction, une interface utilisateur, qui propose au lecteur un appareil sémantique parsemé d’hyperliens. Le design d’interface n’est pas seulement un agencement du contenu, mais une conception qui intègre celui-ci comme élément producteur de données, comme des métadonnées, une base de données, des références, et qui donne au lecteur le statut d’«acteur». La notion de design d’interaction “user interface design” a été formulée par Bill Moggridge, designer industriel et Bill Verplank chercheur en interface homme-machine (IHM) à la fin des années 80 sur le constat que le design des interfaces logiciels et des objets interfaces sont indissociables. Dans l’ouvrage “designing interaction” Bill Moggridge nous explique que pour concevoir et penser une interface, il faut réfléchir aux pratiques des usagers par une recherche anthropologique et sociologique afin de comprendre les échanges entre les individus et les logiciels, mais également avoir une compréhension des représentations, de la navigation et de la connectivité .

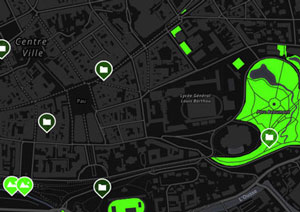

Dans le cadre du cours de la méthodologie de la recherche , une initiation aux méthodes d’enquêtes en sciences sociales appliquées au domaine du design graphique a permis une étude autour d’une thématique commune, «les écritures urbaines, qui façonnent le patrimoine de la ville de Pau». Notre atelier de travail s’est donné pour objectif d’ étudier le patrimoine de la ville de Pau par l’écriture urbaine.

consulter le site des écrits du patrimoine

Ce travail a donné lieu à la création d’une plateforme internet ayant pour but de recueillir, d’organiser et de publier l’ensemble des données produites. Cette activité pédagogique fut l’occasion d’aborder, d’expérimenter et de comprendre les questions de la macrotypographie, de la structure sémantique, d’architexte et d’hyperlien à l’écran. Cet atelier de travail fut un moment d’apprentissage fort, qui par un partage des savoir-faire numériques et techniques a permis d’interroger et de faire évoluer notre pratique du design.

La complexité de ce travail fut de définir l’architecture, l’arborescence et la navigation de cette plateforme web. Par l’établissement du cahier des charges, le contexte, les différentes cibles, les enjeux et les usages de ce projet ont été définis.

La première organisation proposée est la géolocalisation cartographique des données dans l’objectif d’inscrire l’ensemble des contenus récoltés dans un territoire. Afin de mettre en avant le contexte, puisque la notion de patrimoine se construit dans une relation avec un lieu. Lors de l’élaboration de cette plateforme différents niveaux de visualisation des «strates» de données ont aussi été identifiés. Pour cela, un système permettant d’articuler trois niveaux d’information a été envisagé: viz (visualisation pour tout public), data (les données géolocalisées, images, textes, données sonores), meta (des commentaires méthodologiques et pédagogiques constitués des retours des étudiants et des encadrants sur les démarches employées lors des enquêtes). Ainsi, différentes couches d’informations se combinent pour proposer une lecture adaptée à chaque type d’usage, de la simple consultation à l’outil didactique de travail, tel qu’ils ont pu être déterminés au sein du cahier de charges.

Cette expérience enrichissante a permis d’aborder les enjeux de l’édition numérique mais surtout d’aborder le design d’information en mettant en place des systèmes «rationnels» dans l’objectif de rendre compréhensible aux yeux du récepteur l’ensemble des informations contenues dans cette plateforme. Comme le dit Louis Vollaire, «Le design d’information est alors un régulateur de la communication.» . Ce projet a permis de questionner la méthodologie et le processus de travail du designer qui doivent mettre en place des stratégies de conception dans l’intention de transformer des données brutes en informations hiérarchisées et structurées, adaptées à un contexte. La cohérence et la pertinence de celui-ci découle, dans la plupart des cas, de la capacité à mettre en exergue une problématique et à y répondre par un procédé logique et rigoureux.

De plus, cela a confirmé que la macrotypographie numérique transforme le texte et son image. Le concept d’énonciation éditoriale, précédemment cité, peut être un dispositif permettant de mesurer les mutations de celui-ci à l’écran. L’environnement du texte conditionne ses modes d’inscriptions, sa formalisation ainsi que ses pratiques de lectures et ses systèmes d’interaction. En effet, l’écran objet technologique, utilisant des langages de programmation, devient une «machine à texte» et transforme l’ensemble du contenu en une suite d’instructions écrites permettant la formalisation et l’agencement de celui-ci à l’écran. Yves Jeanneret et Emmanuël Souchier soulignent le fait qu’il est important de prendre en compte la matérialité de ce dispositif technique puisqu’il induit et conditionne la pratique de la lecture, mais aussi de l’écriture. Le transfert d’un texte imprimé à un texte numérique n’est pas un passage du réel vers le virtuel. En effet, l’écran est bel et bien un objet qui donne à lire un texte matériel et non virtuel, comme le soulignent Yves Jeanneret et Emmanuël Souchier: l’on ne passe pas d’un monde sans forme à un monde de formes, mais bien d’un monde de formes à un autre monde de formes, dans lequel le mode d’existence de ces formes est distinct. C’est en cela qu’il est important de comprendre le contexte d’inscription du texte dans l’intention de maitriser les paramètres de sa structuration.

LES OBJETS NUMÉRIQUES

-----

Avec l’essor des supports-écrans dans notre quotidien, la diffusion de la connaissance par le langage écrit connaît des mutations qui entrainent des transformations dans les formes éditoriales. Les outils numériques transforment les processus de conception du designer graphique. Celui-ci doit prendre en compte le fait que l’usager doit assimiler des compétences techniques et comprendre les usages de ces écrans pour les manipuler. La technologie des écrans apporte une très grande quantité d’objets numériques aux dimensions et proportions variées qui multiplient les occasions de lecture. L’édition imprimée se transforme en une grande variété de formes qui n’ont ni les mêmes statuts, ni les mêmes usages, ni les mêmes systèmes de diffusion. Pouvons-nous parler d’édition numérique lorsque l’on parle de numérisation, de format PDF ou EPUB ? Un même texte dispose-t-il des mêmes dispositifs sur support tablette, smartphone, ou écran d’ordinateur ?

À travers cette dernière partie, nous allons identifier ce qu’est une édition numérique et dans quelle mesure son dispositif de diffusion participe à la physionomie et à la morphologie du texte.

Le livre numérisé

Un Livre numérisé peut être défini comme étant une opération de portage, de conversion d’une inscription imprimée ou manuscrite vers un support-écran, par un procédé d’encodage informatique. La numérisation des livres a connu une impulsion avec le développement des bibliothèques numériques. Nous pouvons prendre l’exemple de la première bibliothèque numérique, le «Projet Gutenberg» développé par Michael Hart, qui numérisa son premier livre le 4 juillet 1971. C’est un projet idéologique, qui tendait à vouloir rendre accessibles gratuitement le plus grand nombre de livres littéraires à l’image de Johannes Gutenberg, inventeur de l’imprimerie, qui a permis d’augmenter l’accessibilité aux ouvrages textuels. Ce projet en 2010 dénombrait plus de 33 000 livres numérisés disponibles.

La transposition des livres papiers en livres numérisés par les bibliothèques a pour politique de concentrer et de rendre accessible l’ensemble des livres disponibles et non disponibles avec pour but de conserver leur contenu dans leur forme originale. C’est un outil aidant à la recherche, au partage et à l’accès aux connaissances pour le plus grand nombre. Ce procédé participe à la diffusion des textes et à leur stockage, mais ne permet pas la sélection, le copier/coller, les commentaires, le surlignage, l’adaptation de la police de caractères à l’écran, l’indexation, etc. Bien que pouvant être lu à l’écran sous la forme d’un fichier PDF ou JPG, il n’a pas pour vocation d’interroger les usages de lectures sur support-écran. Il nécessite, dans un grand nombre de cas, d’être imprimé afin de pouvoir être consulté/lu dans meilleures conditions.

Édition numérique

Une édition numérique est d’abord un fichier texte informatique traduit et interprété par un logiciel pour permettre son inscription et sa visualisation sur un écran. Il s’inscrit dans une démarche tournée vers la lecture sur un support numérique. Sa matérialité et son contexte de lecture induisent une gestuelle et des usages spécifiques. Le livre numérique est inscrit dans un environnement où tous les éléments font l’objet de calculs. C’est ce que Pierre Mounier nomme: la «dimension computationnelle» ou calculatoire. C’est-à-dire un ensemble d’instructions définies par le fichier texte qui va permettre au logiciel de concevoir et de produire l’image de celui-ci à l’écran. Lorsque nous achetons un livre numérique au format EPUB, nous faisons l’acquisition d’un ensemble de fichiers où ne se trouve pas directement le texte, mais un assemblage d’instructions informatiques. Leurs destinataires sont des programmes qui ont pour but d’interpréter et de calculer l’ensemble des consignes dans le dessein de construire l’affichage du texte acheté.

Au moins trois types d’éditions numériques peuvent être définis. Le premier type est une forme hybride qui, dans la majorité des cas, est un texte natif de l’imprimé transféré sur les écrans sous une forme pouvant être assimilée à la superposition de la culture des écrans et de la culture de l’imprimé. Ce sont des fichiers textes qui sont déconnectés des dispositifs de mise en réseau proposé par le web. Cette forme d’édition cultive la notion de page ou de feuilletage qui, aux yeux des éditeurs, est une gestuelle et une mise en espace indissociable de la pratique de lecture. Par exemple les ouvrages diffusés par la maison d’édition Byook qui proposent un mimétisme de la gestuelle de l’imprimé: «quand on tourne la page cela reste un comportement naturel, ancré et cela on ne l’enlèvera jamais. Nous sommes accrochés au fait que la page puisse se tourner que l’on puisse jouer un peu avec» . Ou encore l’exemple d’Art Book Magazine, une librairie en ligne proposant sur des Ipad la lecture d'ouvrages papiers. En fonction de la négociation des droits d’auteurs et/ou de diffusion, la librairie en ligne propose des adaptations qui vont de la simple transposition du livre papier à une augmentation numérique du contenu comme nous l’explique Jean Luc Lemaire lors sa venue au sein de l’école en 2014 «Certains textes gagneront à être représentés avec une certaine interactivité en leur associant des légendes, des images dans un contexte graphique plus subtil. On peut aussi intégrer du multimédia, des interactions sonores, de la temporalité, etc.» . Le constat est qu’Art Book Magazine conserve les formes du livre imprimé en proposant une lecture sur tablette par un fichier PDF. Ce sont pour la plupart des cas une simple transposition qui questionne de manière restrictive les usages de la lecture à l’écran. Le deuxième type d’édition numérique est un fichier texte qui se dégage des codes et formes de l’imprimé et qui s’inscrit dans un réseau d’objets communicants. Ce type de texte a pour propriété selon Pierre Mounier d’être «réticulaire», c’est-à-dire, qu’il crée des liens visibles et non visibles avec son environnement, être référencé et participer à la création de bases de données qui permettent la circulation et la mise en connexion d’informations. Ce processus de mise en relation est lié au langage sémantique proposé par l’organisation du contenu. En effet, celui-ci crée des données et des métas données lisibles par l’usager, mais aussi par les serveurs. Il propose une structure hypertexte qui permet de créer des renvois vers des énoncés extérieurs. La mutation, ici, est que le fichier texte n’est pas seulement un ensemble d’instructions qui formalise un contenu. Il participe à la création de liens, à la création d’un réseau d’information qui permet de faire des liaisons qui peuvent s’actualiser à tout moment.

Enfin le dernier type, est un fichier texte natif de la culture numérique, qui en plus d’être «réticulaire» et «computationnel», se nourrit et s’entretient par le réseau de son environnement. Autrement dit, c’est un texte qui a pour propriété la lecture et l’écriture, “Read Write Web”. D’après Pierre Mounier , cette expression provient du titre du blog de Richard Macmanus, qui fait lui-même référence à la mémoire vive d’un ordinateur ‟RAM” qui signifie “Random Access Memory”. C’est un principe qui désigne une mémorisation de données où chaque élément peut être, en tout temps, consulté ou modifié.

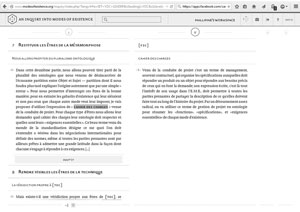

Nous pouvons prendre l’exemple du projet de recherche ‟AIME” , dirigé par Bruno Latour et développé au sein du laboratoire Medialab de Science Po. Ce projet allie une approche sociologique, anthropologique et philosophique, et propose d’«enquêter sur les modes d’existence» [figure 20]. Donato Ricci, designer italien, a proposé un dispositif de recherche numérique dans l’intention de créer une expérience singulière, par le biais d’une interface utilisateur qui intègre le lecteur dans une démarche de recherche. Basé sur la pratique de l’annotation de texte scientifique dans les marges des livres imprimés, Donato Ricci a réfléchi à trois typologies de métadonnées: les commentaires, la critique et la mise en valeur/surlignage de notion.

Le résultat du travail de Bruno Latour est disponible dans une version imprimée et est prolongé par une plateforme web où une interface utilisateur propose aux lecteurs de devenir des co-enquêteurs en participant à la réécriture et à l’annotation de celui-ci. C’est un projet qui interroge les pratiques de la lecture et de la recherche par une interface, dans l’intention d’enrichir et de corriger son contenu par la création d’espaces communautaires qui donnent la possibilité au lecteur de lire, mais aussi d’intervenir sur des zones déterminées du texte pour y ajouter des commentaires, des analyses ou des questionnements. C’est une forme de laboratoire numérique qui explore les usages «lecture/écriture» des environnements-écrans en mobilisant les compétences des usagers afin d’essayer de comprendre les évolutions et les points de friction entre les différents domaines et notions abordés autour des «modes d’existences».

La multiplication des supports numériques

Depuis l’introduction de l’ordinateur personnel dans le milieu domestique, les écrans sont devenus multiples, multiformes et connectés. Ce sont des dispositifs qui remettent en cause notre rapport au texte et à l’image en introduisant de nouveaux usages et de nouvelles gestuelles. Mobiles et portatifs, les écrans transforment notre relation, notre accès à l’information et à la lecture en donnant le don d’ubiquité. En effet, grâce à internet les usagers ont la possibilité de consulter à n’importe quel moment et n’importe où leurs données. Comme le remarque Michel Serres, philosophe et historien des sciences: «maintenant tenant en main le monde» . Autrement dit, la technologie des supports donne la fonction d’ubiquité aux textes numériques permettant de consulter à tout moment des articles, des revues ou encore des journaux d’actualités.

Chaque type d’appareil est une fenêtre ouverte sur le réseau: l’information est conditionnée par le prisme de l’interface de l’objet utilisé. Un téléphone, une tablette ou un ordinateur ne proposent pas les mêmes outils puisqu’ils n’ont pas les mêmes usages. À l’image de Lord Chesterfield, qui au XVIIIe siècle décrit la liaison entre le format d’un livre et son usage, l’hypothèse qu’il en est de même avec nos différents appareils numériques est possible: «les solides folios sont les gens d’affaires avec qui je m’entretiens le matin. Les quartos sont une compagnie plus mêlée et plus accommodante avec laquelle je m’assois après le déjeuner ; et je passe mes soirées avec les légers et souvent frivoles papotages des menus octavos et duodécimos.»

Comme vu précédemment, les propriétés matérielles et dimensionnelles des écrans conditionnent la pratique de la lecture. L’usager ne consulte pas le même type d’information sur un smartphone ou sur un écran d’ordinateur. Par exemple, les liseuses numériques proposent, contrairement aux tablettes ou aux écrans d’ordinateur, un dispositif orienté quasi uniquement sur la lecture de livres numériques. La matérialité des écrans est pensée et conçue dans le but de rendre celle-ci la plus agréable possible. L’écran utilise de l’encre électronique en niveau de gris. C’est une technologie d’affichage sur support souple et mat qui cherche à se rapprocher des qualités lumineuses du papier. Cela permet une lecture moins fatigante pour l’œil humain en proposant un contraste et une luminosité adaptée à la lecture de texte long. Les propriétés des écrans influencent la fatigue visuelle et donc l’attention portée aux textes. Nous avons tous fait l’expérience désagréable d’un écran «brillant» porteur de nombreux reflets gênant la visualisation du contenu. Ces appareils donnent à lire, pour la majorité des cas, des textes sous forme d’EPUB ou de PDF.